トレンド・イベント・セミナーレポート|クラウドxオンプレ

ビッグデータ活用に求められる統合データ分析基盤のアーキテクチャ

IoT・AIの時代にはデータに対するガバナンスを効かせつつ、日々膨大なデータを収集し、蓄積、加工、分析することが求められる。また、データの分析領域の拡大や分析サイクルの短縮により、既存のデータ分析基盤の仕組みだけでは新たなトレンドに対応できない状況が発生している。こうした課題を解決する次世代の統合データ分析基盤として推奨する論理データウェアハウスを解説する。

point

■ 今後のデータ分析で考慮すべき3つのポイント

■ 論理データウェアハウスによる課題解決

■ 既存資産を活かしたデータ分析基盤の機能強化

今後のデータ分析で考慮すべき3つのポイント

IoTやAI(人工知能)に対する関心は高まる一方だ。ロボットの予知保全、タクシーの需要予測、新車配送工期の短縮、センサーを用いた新型自動車保険、建設機械の遠隔監視システムなどの活用事例も相次いで登場している。まさにデジタルトランスフォーメーションの核心として期待されるIoTやAIだが、これらのテクノロジーには具体的にどんな特徴があるのだろうか。

伊藤忠テクノソリューションズ株式会社(略称:CTC)ITプラットフォームビジネス推進第2部のエキスパートエンジニアである後藤真人氏が挙げたのは、「日々連続的に生成される膨大なデータ」「多様なデータ形式(音声、画像、時系列データなど)」「リアルタイム分析」の3つのポイントである。

上記の3つのポイントを踏まえた上で考慮しなければならないのは、データのガバナンスである。「業務上の課題抽出→データ収集・加工→分析→問題解決策の適用」を繰り返すデータ分析のサイクルそのものが変わるわけではない。

「既存のデータソースに加えてIoTのシステムからも膨大なデータを集めるためには、それぞれのデータの出処やタイプ、特性、収集した頻度・粒度などの諸元をしっかり把握し、ガバナンスを徹底する必要があります。データそのものが持つ意味を正確に理解できていなければ、機械学習やディープラーニングをはじめAIによる高度な分析などできるはずがありません」と後藤氏は強調した。

では、膨大かつ多様なデータ、リアルタイム処理といったIoTやAIの要件を満たし、なおかつガバナンスを確保できるデータ分析基盤をどのように構築すべきだろうか。

これまでデータ分析基盤は、主に「エンタープライズデータウェアハウス(EDW)」「目的別データマート(DM)」「ハブ&スポーク」のアーキテクチャーを組み合わせることで構築してきた。だが、IoTやAIといった仕組みを取り込む上で、「この従来型のパターンでは対応は困難なのが現実です」と後藤氏は指摘し、次の5つの課題を挙げた。

第1は「セマンティックレイヤー(共通エンタープライズ情報モデル)がBIツールに依存する」ことだ。さまざまなデータソースに対して複数のBIツールを個別に立てなければならない。あるいはBIツールをリプレースする場合に、セマンティックレイヤーをあらたに作り直さないといけない。

その結果、第2の課題として「統合的なデータガバナンスが困難」になる。特に多目的DMを運用する際に、この課題が顕在化する。

第3は「RDBのみでは非構造化データを扱えない」ことで、音声、画像、時系列データなどを扱う仕組みを別途考えなくてはならない。

第4は、「データ増加に応じてコストが増大する」ことである。従来型のEDWでも数百テラバイトからペタバイト級のデータを蓄積することは可能だが、そのためのハードウェアやソフトウェアのライセンス費は巨額になってしまう。

そして第5は、「各データソースからのETL(抽出/加工・変換/ロード)がリアルタイム処理に非対応」であることだ。バッチでも分単位レベルでの処理が可能だが、ストリーム形式のデータ処理にはどうしても遅延が発生してしまうことである。

論理データウェアハウスによる課題解決

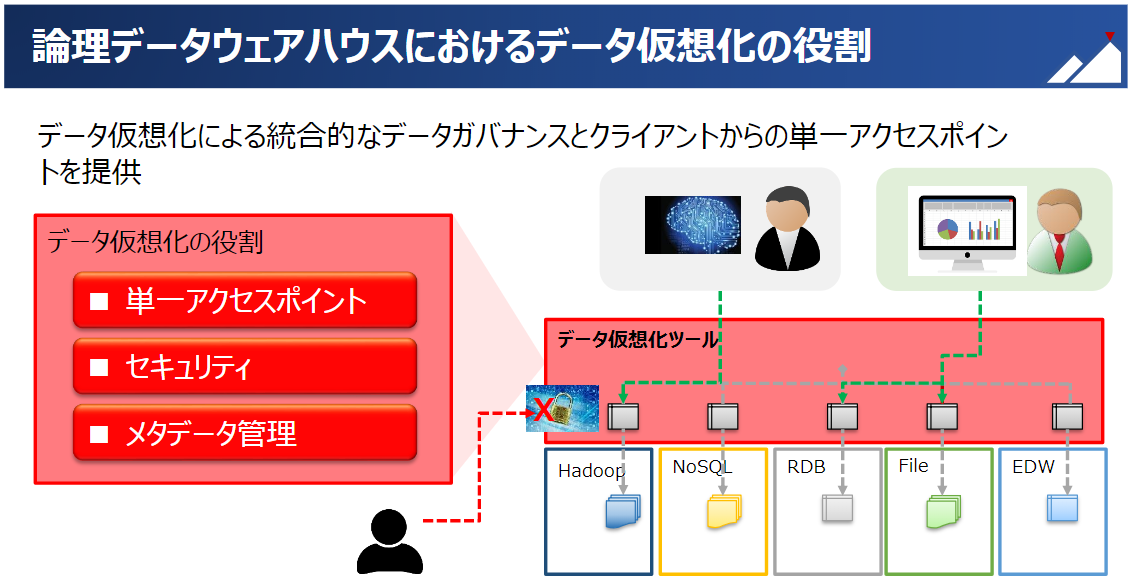

そこで提唱するのが論理データウェアハウスへの移行である。「データ仮想化によりデータ管理を一元化します」と後藤氏は、このアプローチを説明した。

データ仮想化は、データ分析基盤に対して単一のアクセスポイントを提供する。データ仮想化ツールの下にHadoop、NoSQL、RDB、ファイル、EDWといった異なるアーキテクチャーをもつデータソースを統合し、仮想ビューもしくは仮想テーブルを定義することで、共通のセマンティックレイヤーを構築するのである。

これによって何がよくなるのか。「従来はクライアントツールから各データソースの構造や特性を理解した上で直接参照しなければならなかった操作が、仮想ツール内で標準化されて統合されます」。

ベースとなっているのは、メタデータ管理の機能だ。データソースごとに行われているテーブルやファイルの定義情報を統合的に管理するのである。

「たとえば同じ『売上』という項目であっても、データソースごとに集計期間が違っている場合があります。こうした差異をメタデータ情報を基に明らかにすることで、分析者はどのデータを使うべきかを判断することができます。また、管理者に対しても各データソースのデータを可視化し、メタデータの定義やメンテナンスをGUI上で容易に行うことができる管理ツールを提供します。こうした仕組みがないと、大規模かつ多様なデータの蓄積や分析に柔軟に対応することができません」。

また、従来のデータ分析基盤では各データソースやクライアントツールのセキュリティを個別に設定しなければならないという問題があった。管理ポイントが複数に分散すると、どうしてもガバナンスが行き届かず対策に“漏れ”が発生し、情報セキュリティ上の重大な事態を招くリスクが高まる。

この課題を解決する上でもデータ仮想化は非常に重要な役割を担う。「複数のデータソースを統合することで、セキュリティ面でも統一したポリシーを適用することが可能となります」と後藤氏は強調した。

なお、データ仮想化を実現する仕組みとしては、Cisco Information Serverなどの専用ツールを利用するほか、SAP HANAのスマートデータアクセス機能やTeradata QueryGridなど、既存のEDWに包括されたフェデレーション機能を利用する方法もある。

既存資産を活かしたデータ分析基盤の機能強化

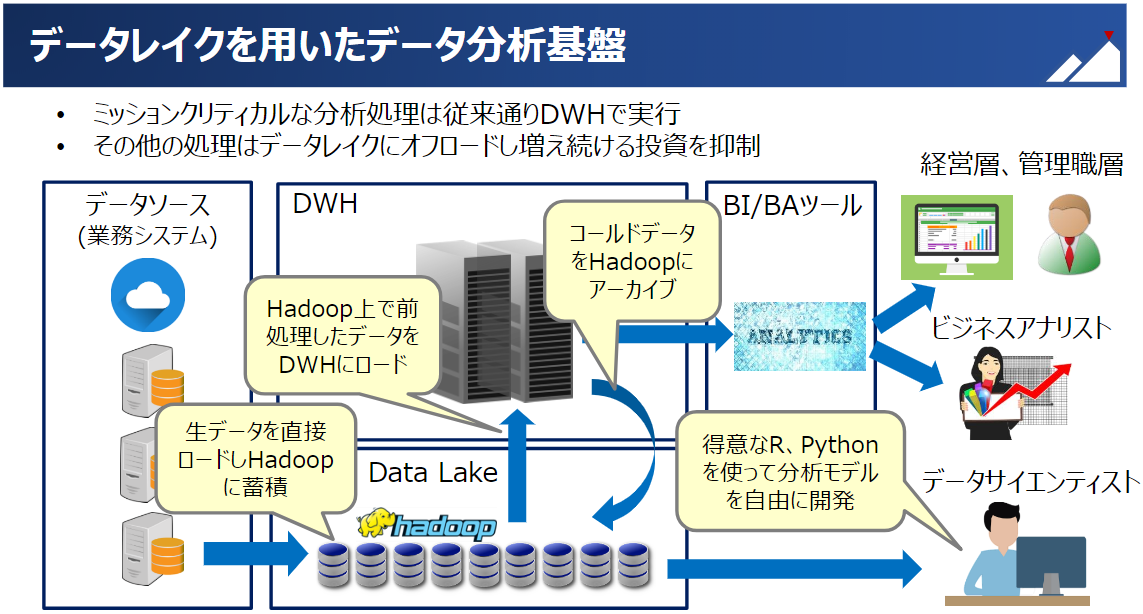

さらに論理データウェアハウスの前段にデータレイクを配置することで、大量データおよび多様なデータ形式にも柔軟に対応することができる。

データレイクの主な役割は、データの前処理や分析者へのサンドボックの提供、データのアーカイブなどである。「非構造化データを含む生データの蓄積や加工をデータレイクにオフロードし、EDWに対する投資を抑制することができます」と後藤氏は語った。

これにより、たとえばHadoopに対しても、その拡張性や先進テクノロジー、コストパフォーマンスを有効に活かすことが可能となる。ミッションクリティカルな業務の分析処理については従来どおりデータウェアハウスを介してBI/BAツール上で実行し、経営層や管理職層、あるいは企画部門のビジネスアナリストなどの要求に応える。一方、各データソースの生データを直接ロードしてHadoopに蓄積し、統計解析やマイニングモデルの開発などより専門的な分析を担うデータサイエンティストに提供するのである。

また、リアルタイム処理についてはHadoop単体で実装するほか、既存のEWDの仕組みを利用し、Hadoopの基盤とSAP HANAをLambdaアーキテクチャーで統合して対応することも可能だ。

「データ仮想化による統合的なデータガバナンス、柔軟なフェデレーション構成、Hadoopによる非構造化データへの対応、EWDの負荷をオフロードするデータレイクといった特長をもつ論理データウェアハウスにより、既存資産を有効に活用したデータ分析基盤の機能強化が可能となります」と後藤氏。

次世代の基盤に向けたシステムの刷新や再構築については、CTCとしても積極的にサポートしていく。